嵌入式硬件

maven

极限编程

矩阵

音视频

指针

csdn热榜

insert into

WT-VL53L0 L1

医学

产品设计误区

卷积神经网络

网站安全防护

数字电路

主从复制

paddlepaddle

短时傅里叶变换

EmguCV

hotseat图标

Cancel

transformers

2024/5/6 16:44:08各种预训练模型的理论和调用方式大全

诸神缄默不语-个人CSDN博文目录

本文主要以模型被提出的时间为顺序,系统性介绍各种预训练模型的理论(尤其是相比之前工作的创新点)、调用方法和表现效果。

最近更新时间:2023.5.10 最早更新时间:2023.5.10

BertRobe…

transformers-Generation with LLMs

https://huggingface.co/docs/transformers/main/en/llm_tutorialhttps://huggingface.co/docs/transformers/main/en/llm_tutorial停止条件是由模型决定的,模型应该能够学习何时输出一个序列结束(EOS)标记。如果不是这种情况,则在…

详解Hugging Face Transformers的TrainingArguments

前言:

TrainingArguments是Hugging Face Transformers库中用于训练模型时需要用到的一组参数,用于控制训练的流程和效果。

使用示例:

from transformers import Trainer,TrainingArguments

training_args TrainingArguments(output_dir&q…

ModuleNotFoundError: No module named ‘transformers.modeling_bert‘解决方案

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的…

初探BERTPre-trainSelf-supervise

初探Bert

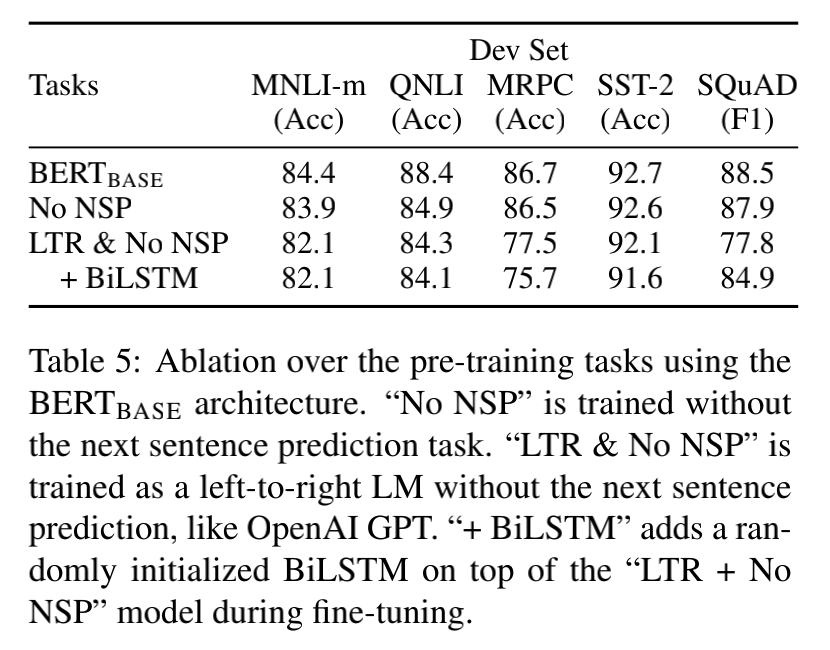

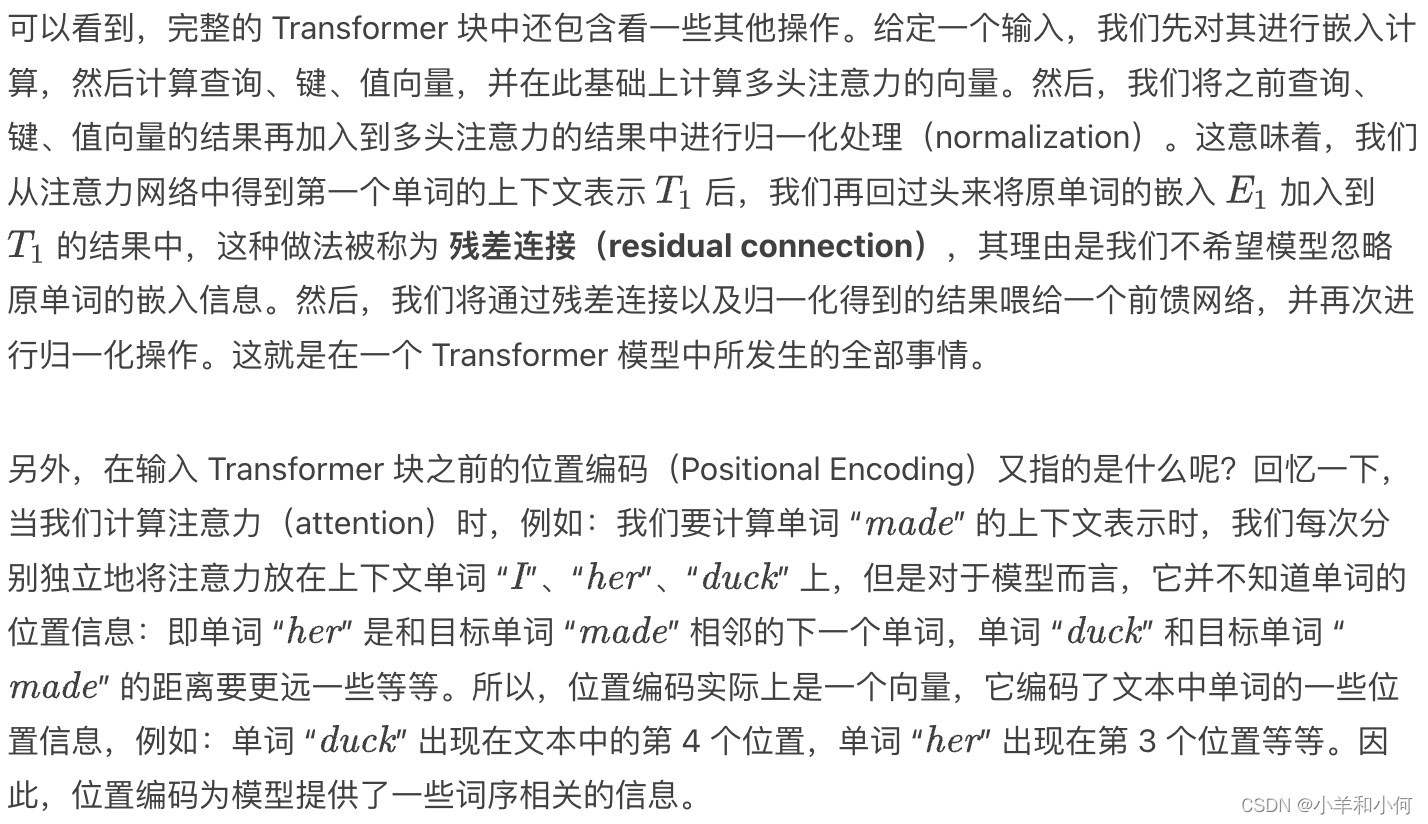

因为一次偶然的原因,自己有再次对Bert有了一个更深层地了解,特别是对预训练这个概念,首先说明,自己是看了李宏毅老师的讲解,这里只是尝试进行简单的总结复述并加一些自己的看法。

说Bert之前不得不说现在的…

Lecture 11 Contextual Representation

目录 Problems with Word Vectors/Embeddings 词向量/嵌入的问题RNN 语言模型Bidirectional RNN 双向 RNNEmbeddings from Language Models 基于语言模型的嵌入ELMo 架构Downstream Task: POS Tagging 下游任务:词性标注ELMo 的表现如何?Other Findings上…

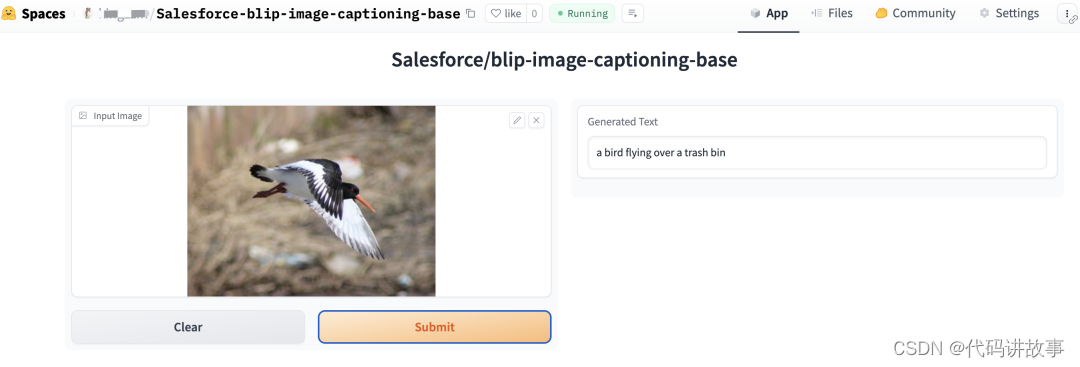

快速使用transformers的pipeline实现各种深度学习任务

目录

引言

安装

情感分析

文本生成

文本摘要

图片分类

实例分割

目标检测

音频分类

自动语音识别

视觉问答

文档问题回答

图文描述 引言

在这篇中文博客中,我们将深入探讨使用transformers库中的pipeline()函数,它为预训练模型提供了一个简单且快速的推理方法。…

NLP神器Transformers入门简单概述

在这篇博客中,我们将深入探索 🤗 Transformers —— 一个为 PyTorch、TensorFlow 和 JAX 设计的先进机器学习库。🤗 Transformers 提供了易于使用的 API 和工具,使得下载和训练前沿的预训练模型变得轻而易举。利用预训练模型不仅能减少计算成本和碳足迹,还能节省从头训练…

HuggingFace Hub系列:推动NLP前进的协作平台

在当今快速发展的机器学习(ML)领域,没有任何一个公司,包括科技巨头,能够独立“解决AI”。这是一个需要通过共享知识和资源在社区中协作来实现的目标。正是基于这个信念,Hugging Face Hub应运而生,它是一个集成了超过12…

【HuggingFace】Transformers(V4.34.0 稳定)支持的模型

Transformer 4.43.40 版本是自然语言处理领域的一个重要工具包,为开发者提供了丰富的预训练模型资源,可以用于各种文本处理任务。在这个版本中,Transformer 支持了众多模型,每个模型都具有不同的优势和适用领域。下面是一个 Trans…

HuggingFace Transformers教程(1)--使用AutoClass加载预训练实例

知识的搬运工又来啦

☆*: .。. o(≧▽≦)o .。.:*☆

【传送门>原文链接:】https://huggingface.co/docs/transformers/autoclass_tutorial 🚗🚓🚕🛺🚙🛻🚌Ƕ…

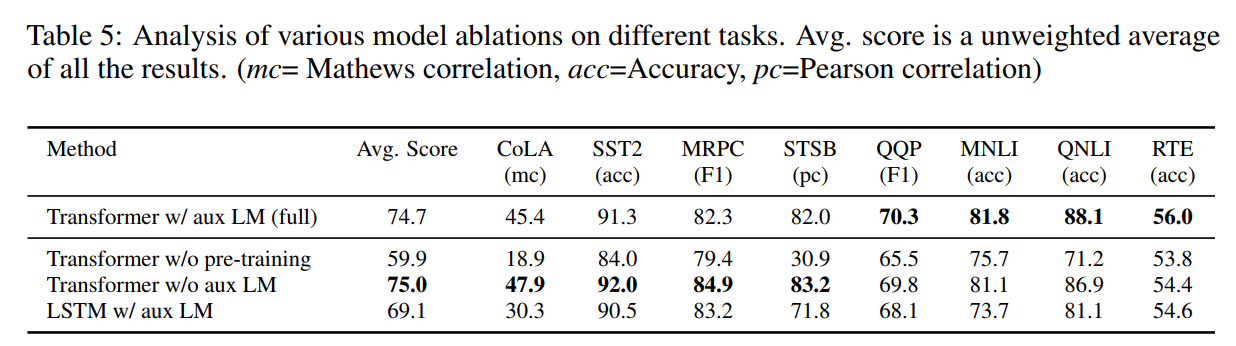

Re45:读论文 GPT-1 Improving Language Understanding by Generative Pre-Training

诸神缄默不语-个人CSDN博文目录 诸神缄默不语的论文阅读笔记和分类

论文全名:Improving Language Understanding by Generative Pre-Training 论文下载地址:https://www.mikecaptain.com/resources/pdf/GPT-1.pdf

本文是2018年OpenAI的工作,…

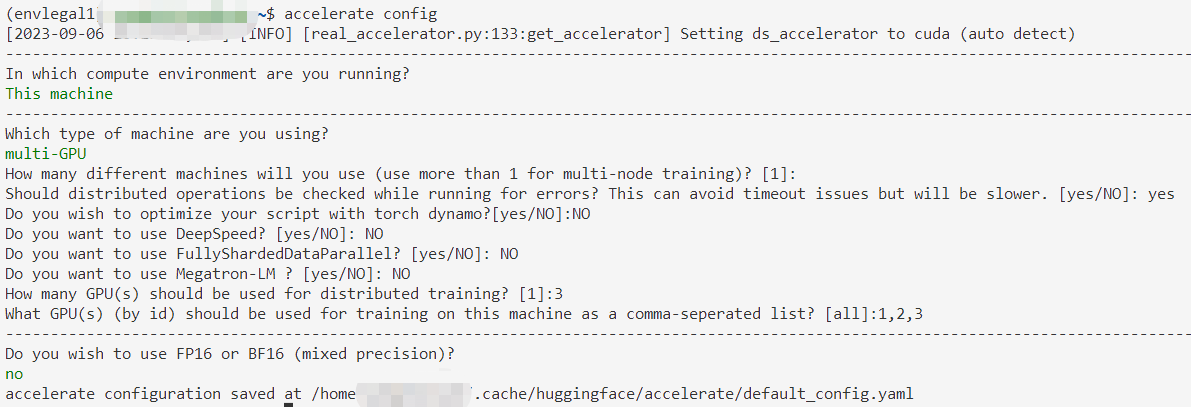

用huggingface.Accelerate进行分布式训练

诸神缄默不语-个人CSDN博文目录

本文属于huggingface.transformers全部文档学习笔记博文的一部分。 全文链接:huggingface transformers包 文档学习笔记(持续更新ing…)

本部分网址:https://huggingface.co/docs/transformers/m…

使用transformers过程中出现的bug

1. The following model_kwargs are not used by the model: [encoder_hidden_states, encoder_attention_mask] (note: typos in the generate arguments will also show up in this list)

使用text_decoder就出现上述错误,这是由于transformers版本不兼容导致的 …

ModuleNotFoundError: No module named ‘transformers_modules.chatglm-6b_v1‘的解决方案

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的…

不乱码、下载 Transformers 模型 (抱抱脸、model)

不乱码、下载 Transformers 模型 (抱抱脸、model)

概述

目的: 因为需要对预训练模型等做一些查看、转移操作,不想要乱码,不想频繁下载模型等;

a. (可不乱码) 使用 huggingface_hub 的 snapshot_download(推荐);b. (不乱码) 使用 wget 手动下载;c. 使用…

LLM - Transformer LLaMA2 结构分析与 LoRA 详解

目录

一.引言

二.图说 LLM

1.Transformer 结构

◆ Input、Output Embedding

◆ PositionEmbedding

◆ Multi-Head-Attention

◆ ADD & Norm

◆ Feed Forward

◆ Linear & Softmax

2.不同 LLM 结构

◆ Encoder-Only

◆ Encoder-Decoder

◆ Decoder-Only

…

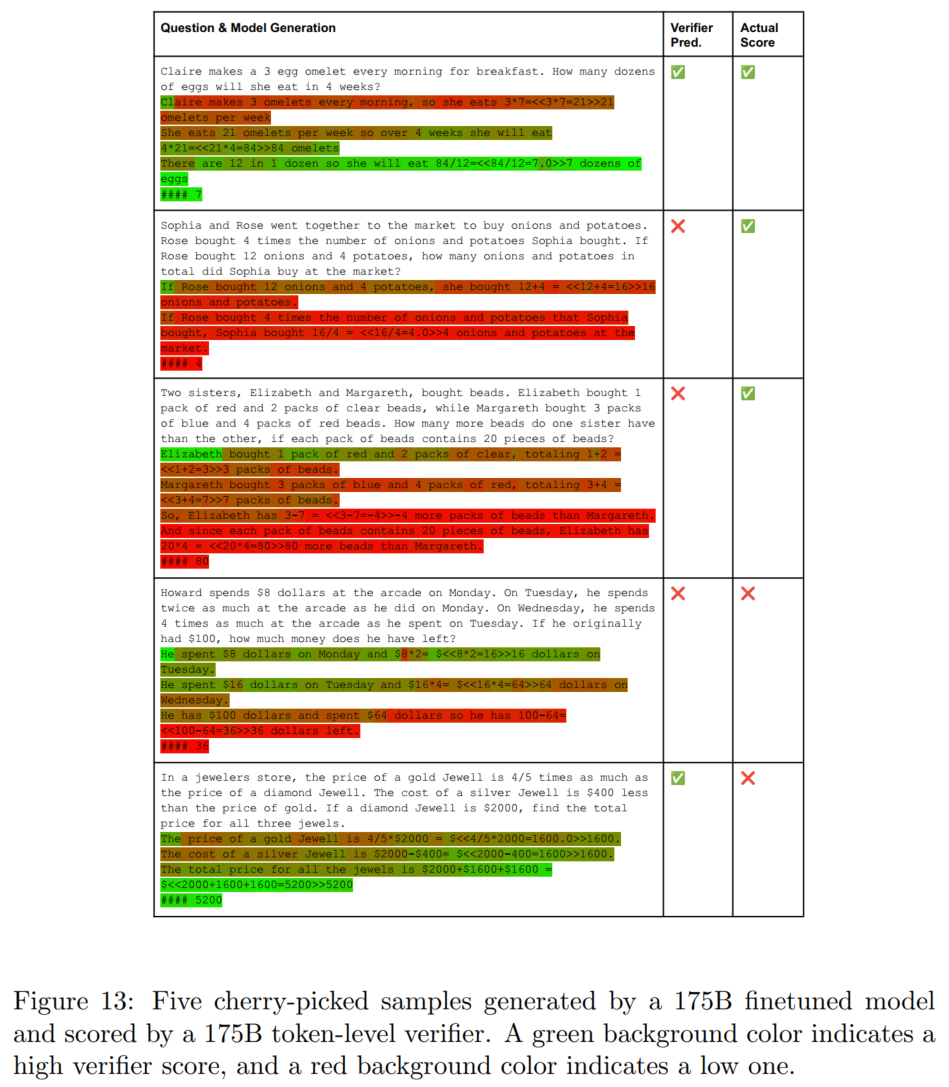

Re44:数据集 GSM8K 和 论文 Training Verifiers to Solve Math Word Problems

诸神缄默不语-个人CSDN博文目录

论文全名:Training Verifiers to Solve Math Word Problems GSM8K数据集原始论文

OpenAI 2021年的工作,关注解决MWP问题(具体场景是小学(grade school)数学题),…

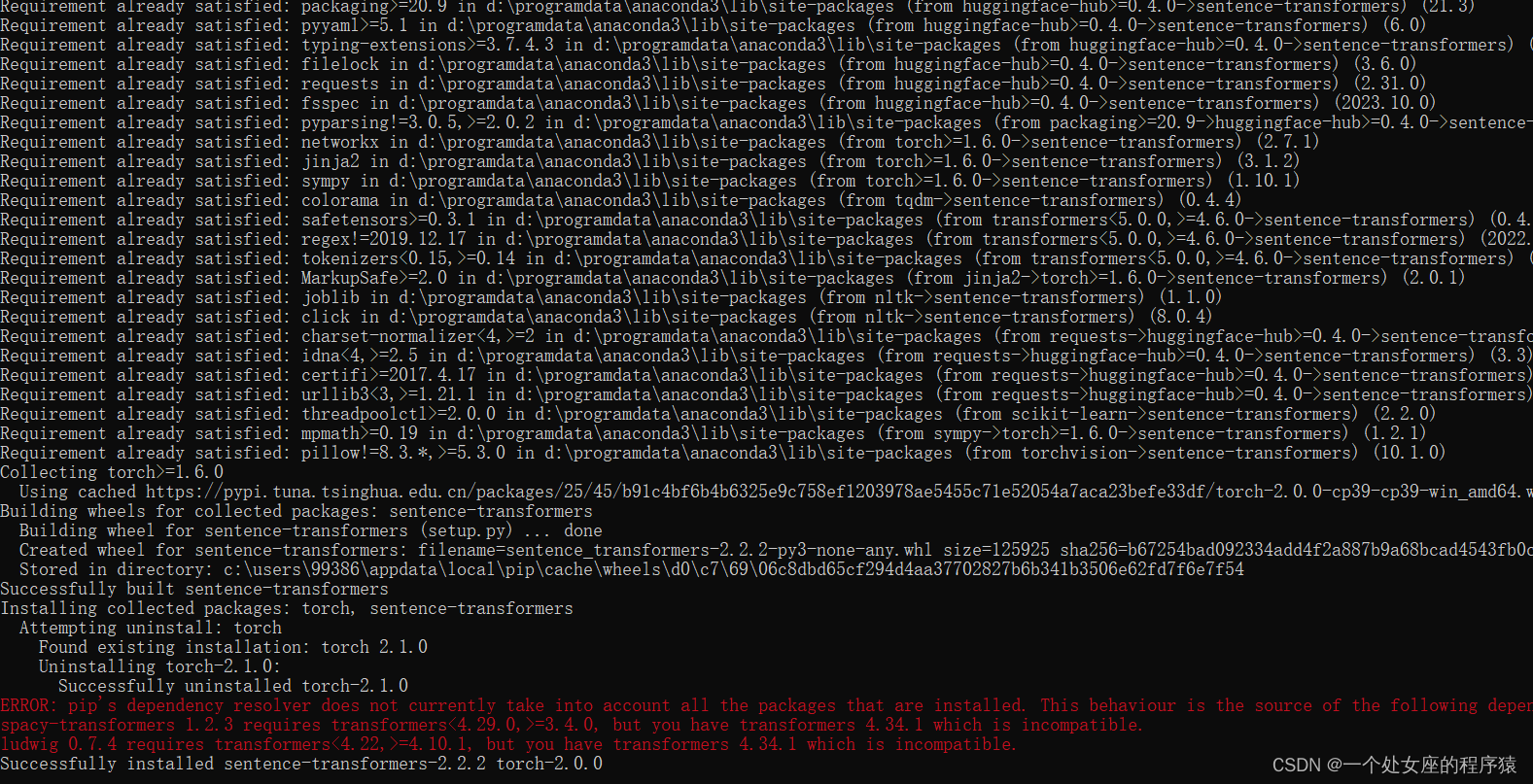

Py之sentence-transformers:sentence-transformers的简介、安装、使用方法之详细攻略

Py之sentence-transformers:sentence-transformers的简介、安装、使用方法之详细攻略 目录

sentence-transformers的简介

1、一些亮点包括

2、可以使用此框架进行以下用途

3、支持的预训练模型

sentence-transformers的安装

sentence-transformers的使用方法 …

prompt工程(持续更新ing...)

诸神缄默不语-个人CSDN博文目录

我准备想办法把这些东西整合到我的ScholarEase项目里。到时候按照分类、按照prompt生成方法列一堆选项,用户自己生成prompt后可以选择在ScholarEase里面聊天,也可以复制到别的地方(比如ChatGPT网页版之类的&a…

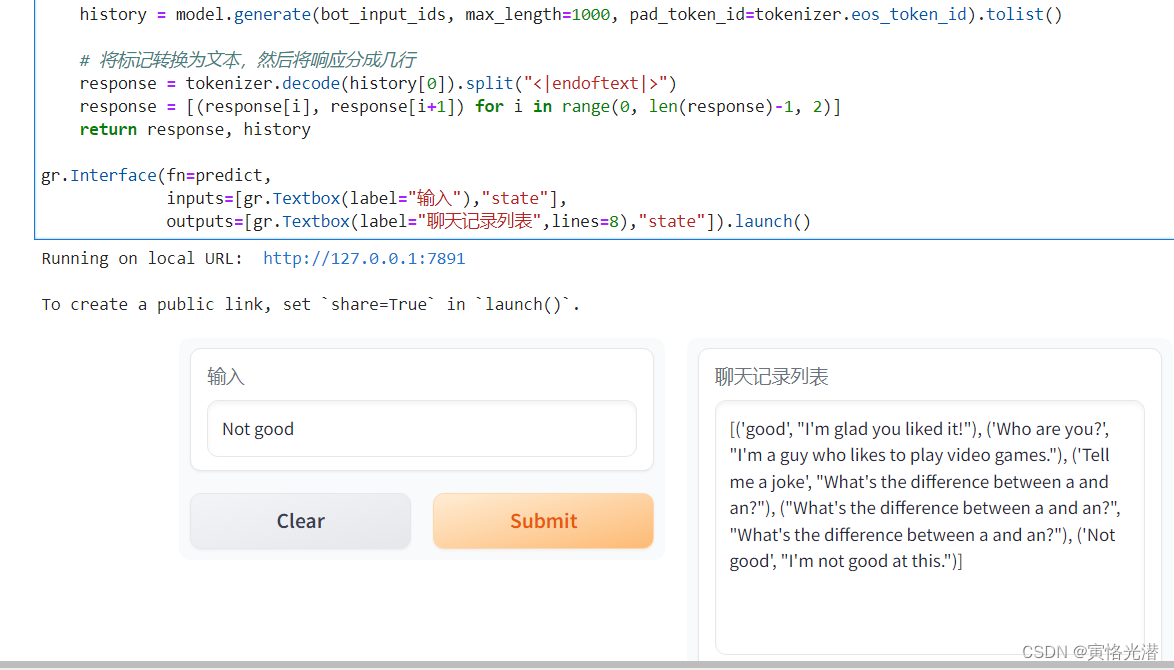

Gradio的web界面演示与交互机器学习模型,全局状态与会话状态《4》

全局状态和会话状态,对于程序员来说都是很熟悉的了,开发中会经常遇到,这里看下在Gradio中是怎么使用的,以及对GPT2的一点介绍

一、Global State全局状态

如果定义的函数想要访问外部的数据,可以将变量写在外面成为一…

pyinstaller打包Transformers 报错No such file or directory

问题描述

Traceback (most recent call last):

File "transformers\utils\import_utils.py", line 1086, in get_module

File "importlib_init.py", line 127, in import_module

File "<frozen importlib._bootstrap>", line 1006, in _g…

transformers-Causal lanuage modeling

https://huggingface.co/docs/transformers/main/en/tasks/language_modelinghttps://huggingface.co/docs/transformers/main/en/tasks/language_modelingcausal lanuage model常用于文本生成。预测token系列中的下一个toekn,并且model只能关注左侧的token…

Ubuntu 安装transformers 报错error can‘t find rust compiler

问题描述

Ubuntu 20.04 使用 pip 安装 transformers 库遇到报错:error: cant find Rust compiler. 下面是报错信息的后半部分。

running build_extrunning build_rusterror: cant find Rust compilerIf you are using an outdated pip version, it is possible a…

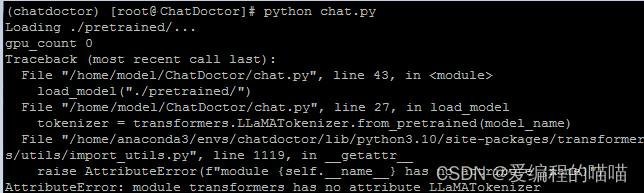

AttributeError: module transformers has no attribute LLaMATokenizer解决方案

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的…

huggingface transformers库中LlamaForCausalLM

新手入门笔记。

LlamaForCausalLM 的使用示例,这应该是一段推理代码。

from transformers import AutoTokenizer, LlamaForCausalLMmodel LlamaForCausalLM.from_pretrained(PATH_TO_CONVERTED_WEIGHTS)

tokenizer AutoTokenizer.from_pretrained(PATH_TO_CONVE…

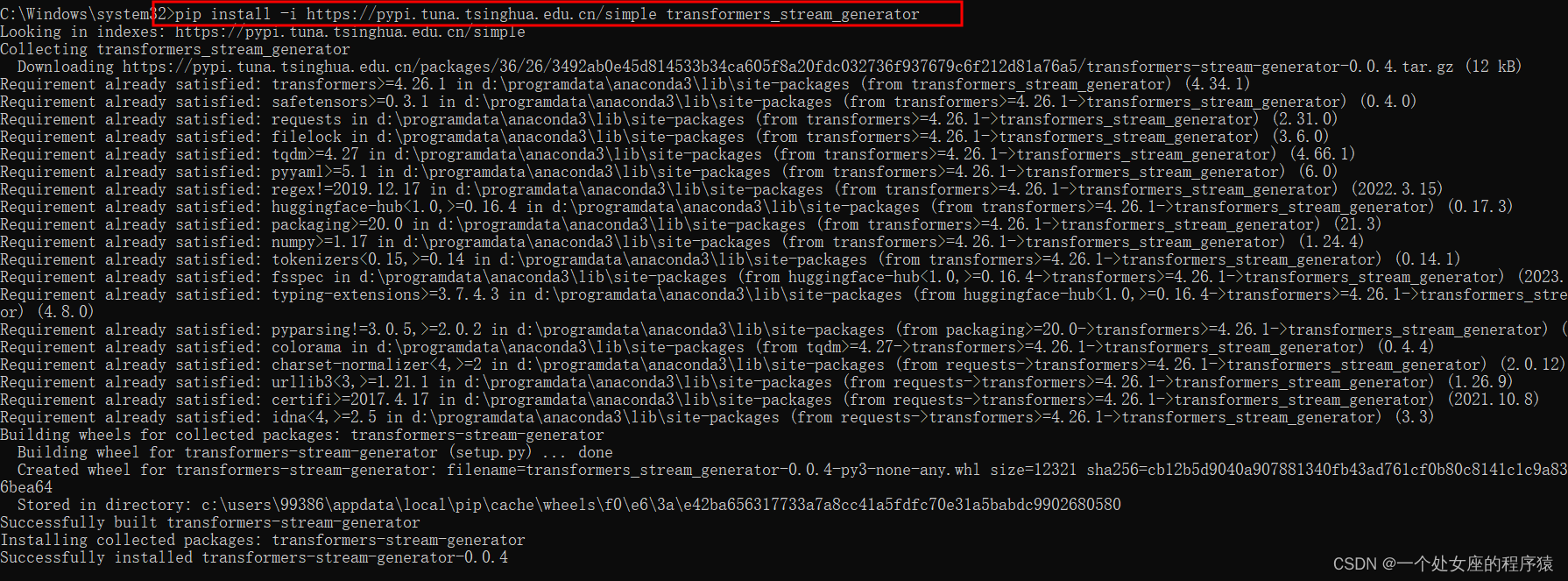

Py之transformers_stream_generator:transformers_stream_generator的简介、安装、使用方法之详细攻略

Py之transformers_stream_generator:transformers_stream_generator的简介、安装、使用方法之详细攻略 目录

transformers_stream_generator的简介

1、Web Demo

T1、original

T2、stream

transformers_stream_generator的安装

transformers_stream_generator的…

ModuleNotFoundError: No module named ‘transformers.modeling_bart‘解决方案

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的…

【自然语言处理】第3部分:识别文本中的个人身份信息

自我介绍 做一个简单介绍,酒架年近48 ,有20多年IT工作经历,目前在一家500强做企业架构.因为工作需要,另外也因为兴趣涉猎比较广,为了自己学习建立了三个博客,分别是【全球IT瞭望】,【…

HuggingFace的transfomers库

tokenizer

我获取了opt类型的tokenizer,那么enc是什么类型呢?有哪些方法呢?

from transformers import AutoTokenizer

enc AutoTokenizer.from_pretrained(facebook/opt-125m)

可以通过print(enc)看到,enc是GPT2TokenizerFast…

transformers pipeline出现ConnectionResetError的解决方案

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的…

AttributeError: ‘FieldInfo‘ object has no attribute ‘required‘.

诸神缄默不语-个人CSDN博文目录

这个bug是在安装doccano包之后,在运行transformers代码时出现的。

核心报错信息:

RuntimeError: Failed to import transformers.models.bert.modeling_bert because of the following error (look up to see its trac…

智障版本GPT3实现

背景,实现GPT3,采用python代码。调库hf及tf2.0+基础。

由于完全实现GPT模型及其预训练过程涉及大量的代码和计算资源,以下是一个基于TensorFlow 2.x的简化版GPT模型构建和调用的示例。请注意,这仅展示了模型的基本结构,实际运行需替换为真实数据集和预处理步骤,且无法直…

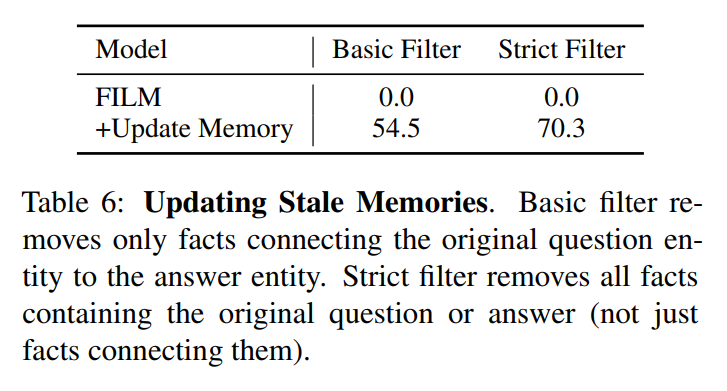

Re60:读论文 FILM Adaptable and Interpretable Neural Memory Over Symbolic Knowledge

诸神缄默不语-个人CSDN博文目录 诸神缄默不语的论文阅读笔记和分类

论文名称:Adaptable and Interpretable Neural Memory Over Symbolic Knowledge 模型名称:Fact Injected Language Model (FILM)

NAACL版网址:https://aclanthology.org/2…

HuggingFace——Tokenizer的简单记录

Tokenizer [ 中文Course | API|详述文档]

下载使用

针对AutoTokenizer来说,如果是从在线仓库中下载,其是要访问: commit_hash kwargs.get("_commit_hash", None)resolved_config_file cached_file(pretrained_model_name_or_pa…

transformers-AutoClass

https://huggingface.co/docs/transformers/main/en/autoclass_tutorialhttps://huggingface.co/docs/transformers/main/en/autoclass_tutorialAutoClass可以自动推断和加载给定checkpoint的正确架构。

对于文本,使用Tokenizer将文本转换为token序列,创…

HugggingFace 推理 API、推理端点和推理空间相关模型部署和使用以及介绍

HugggingFace 推理 API、推理端点和推理空间相关模型部署和使用以及介绍。

Hugging Face是一家开源模型库公司。

2023年5月10日,Hugging Face宣布C轮1亿美元融资,由Lux Capital领投,红杉资本、Coatue、Betaworks、NBA球星Kevin Durant等跟投…